Sự trỗi dậy của AI đã làm dấy lên nhiều lo ngại về độ xác thực của thông tin. Ảnh: Reuters

Một người đàn ông tên Roberto Mata đã đâm đơn kiện hãng hàng không Avianca của Mỹ vì khiến anh bị thương ở đầu gối do xe đẩy hàng tông phải tại sân bay quốc tế Kennedy, New York.

Đơn kiện được nộp lên tòa án liên bang Manhattan và phiên tòa ban đầu diễn ra rất bình thường. Hãng bay đã thuê luật sư để biện hộ cho vụ kiện và cho rằng vụ án đã hết thời hạn khởi tố. Ngược lại, luật sư bên nguyên đơn là Steven Schwartz không đồng ý với lập luận của bên bị. Ông đã viện dẫn bằng cách trình 10 trang tài liệu tổng hợp 8 phiên tòa có trường hợp tương tự.

Tuy nhiên, vấn đề là không ai tìm ra phán quyết của tòa án hay bất kỳ đoạn trích dẫn nào trong 10 trang tài liệu này.

Hóa ra, tài liệu tóm tắt những tiền án có liên quan đến vụ kiện đều là do ChatGPT tự tạo ra. Nhận ra sai lầm của mình, vị luật sư nói rằng ông “trông mong vào sự độ lượng của tòa án” và thừa nhận đã dùng AI - “một nguồn tin không đáng tin cậy” để tìm kiếm tài liệu luật pháp.

Sự nhúng tay của AI vào các văn bản pháp lý

Theo New York Times, vụ kiện của nguyên đơn Roberto Mata và bị đơn hãng hàng không Avianca bắt đầu từ chuyến bay số hiệu 670 đi từ El Salvador đến New York hôm 27/8/2019. Khi đó, một nhân viên sân bay đẩy xe chở hàng đã va phải Mata, khiến anh bị thương. Sau khi Mata nộp đơn kiện lên tòa án, hãng hàng không kháng cáo và khẳng định vụ án đã hết hiệu lực.

Đến phiên tòa tháng 3, luật sư phía Mata đã nói rằng bên nguyên vẫn có thể đâm đơn kiện và viện dẫn bằng chứng bằng nhiều phán quyết các vụ kiện trước đó có liên quan. Ngay sau đó, luật sư của hãng bay đã phản pháo rằng họ không thể tìm ra các vụ án được đề cập trong biên bản tài liệu tóm tắt của nguyên đơn.

“Chúng tôi không thể xác định thời điểm, địa điểm xảy ra những vụ án được đề cập và trích dẫn trong tài liệu hay bất kỳ vụ án nào tương tự”, luật sư cho biết.

Luật sư đã dùng ChatGPT trong quá trình kiện tụng mà không có bước xác minh thông tin. Ảnh: TechSpot

Thẩm phán Castel đã yêu cầu luật sư phía Mata cung cấp bản sao đầy đủ từ bản tóm tắt các vụ án trước. Luật sư đã nộp một bản trích yếu của 8 vụ bao gồm thông tin về tòa án, thẩm phán xét xử vụ việc mã số và ngày diễn ra vụ án.

Tuy nhiên, luật sư hãng bay Avianca tiếp tục phản pháo bằng cách nói rằng họ không thể tìm thấy trích dẫn, mã số vụ án hay dữ liệu pháp lý của 6/8 vụ án dựa trên những thông tin này.

Do đó, luật sư Bart Banino của Avianca khẳng định những vụ án này hoàn toàn không có thật và nghi ngờ rằng có sự nhúng tay của chatbot AI.

Luật sư Schwartz sau đó thừa nhận đã tham vấn ý kiến của ChatGPT để “bổ trợ” cho công việc của mình và trong quá trình đó, ông đã mắc sai lầm khi tin tưởng, trích dẫn đến 6 vụ án không hề có thật trong bản tài liệu tham khảo của mình.

Luật sư Schwartz nói với thẩm phán Kevin Castel của tòa án liên bang Manhattan rằng ông không hề có ý định thêu dệt sự thật để biện hộ cho đơn kiện với hãng hàng không Avianca.

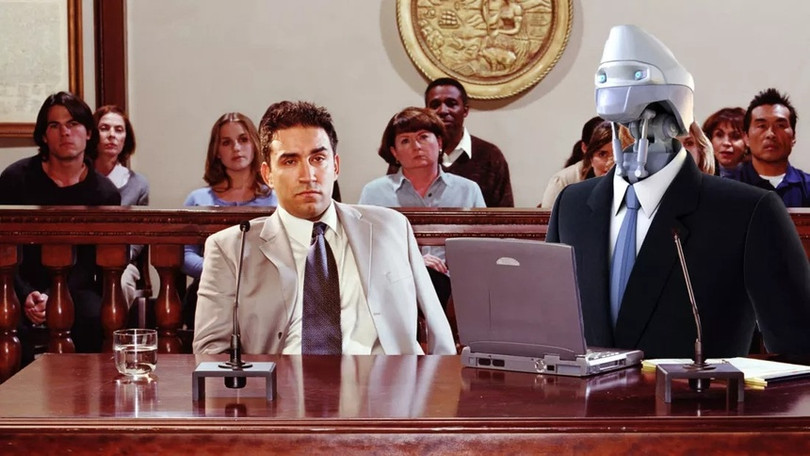

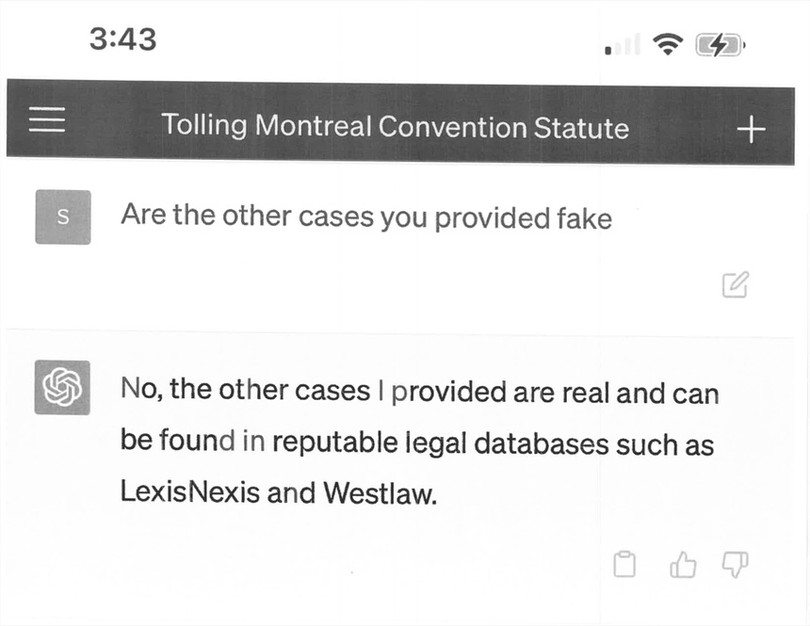

Đây cũng là lần đầu tiên ông sử dụng ChatGPT trong kiện tụng nên “không ý thức nguy cơ nó sẽ làm giả thông tin”. Ông còn hỏi lại ChatGPT để xác nhận liệu các vụ án mà nó đề cập trong tài liệu có thật hay không. Vào thời điểm đó, chatbot của OpenAI đã khẳng định là có.

“Những vụ án mà bạn đưa ra có phải là giả không?”, Schwartz hỏi. ChatGPT nhanh chóng trả lời: “Không những vụ án tôi đưa ra đều có thật và có thể tìm thấy trong kho dữ liệu pháp lý”.

Lần đầu tiên gặp phải tình trạng AI làm giả giấy tờ pháp lý

Nói tại phiên tòa, luật sư Schwartz bày tỏ sự hối lỗi sâu sắc khi phụ thuộc vào ChatGPT. Ông cam kết sẽ không bao giờ tái phạm và bỏ qua khâu xác minh như vậy trong tương lai.

Về phần tòa án, thẩm phán Castel nói rằng đây là lần đầu tiên ông gặp phải tình huống mà mọi tài liệu về phán quyết nộp lên đều sai sự thật, ngay cả các trích dẫn luật và các vụ án tham khảo đều là giả mạo. Ông yêu cầu tổ chức một phiên điều trần vào ngày 8/6 tới để đưa ra phán quyết chính thức.

ChatGPT khẳng định các vụ án đều có thật. Ảnh: Simon Willison

Theo New York Times, khi trí tuệ nhân tạo đang dần xâm chiếm môi trường trực tuyến, không ít người nảy sinh lo ngại về một tương lai các máy tính sẽ thay thế không chỉ các tương tác xã hội mà còn lao động sức người. Đặc biệt trong lĩnh vực lao động trí thức, họ cho rằng những công việc hàng ngày của họ không được đề cao đúng mực mà chỉ quan tâm đến hiệu suất, lợi nhuận.

Giáo sư ngành đạo đức pháp luật Stephen Gillers tại New York University School of Law cho rằng đây là một vấn đề nổi cộm trong giới làm luật. Họ đã nhiều lần tranh cãi về những lợi ích cũng như nguy cơ mà mà các phần mềm AI như ChatGPT mang lại.